Бесплатный фрагмент - Человеко-ориентированный искусственный интеллект: UX, аналитика, этика

Сведения об авторе

Юлия Вересова — исследователь в области HCAI, поведенческой аналитики и проектирования взаимодействия человека и ИИ.

Профессиональные интересы включают разработку адаптивных ИИ-интерфейсов, построение этически устойчивых цифровых сред, исследование когнитивных и эмоциональных механизмов взаимодействия с интеллектуальными системами, а также создание моделей пользовательского поведения в условиях автоматизации и генеративного ИИ.

Предисловие

Книга посвящена основам и прикладным аспектам Human-Centered Artificial Intelligence (HCAI). Цель книги — сформировать у читателя целостное понимание принципов HCAI и подготовить его к осознанной работе в сфере проектирования, оценки и сопровождения интеллектуальных систем.

Материалы структурированы по модулям и соответствуют академической логике изучения предмета в формате учебного курса. Каждый раздел включает теоретическую основу, методические подходы, практические акценты и глоссарий ключевых терминов. Отдельное внимание уделено таким аспектам, как объяснимость моделей, доверие к ИИ, когнитивная нагрузка, пользовательские исследования в AI-интерфейсах, юридические нормы и анти-паттерны UX в интеллектуальных продуктах.

Книга ориентирована на UX-исследователей, аналитиков, дизайнеров взаимодействия, разработчиков ИИ-систем, преподавателей и студентов старших курсов. Она может быть полезна как для самостоятельного изучения, так и в рамках образовательных программ по HCAI, цифровой этике, взаимодействию человек–технологии и гуманитарным аспектам искусственного интеллекта.

Примечание: В тексте упоминаются организации, деятельность которых запрещена на территории РФ.

Глава 1. Введение в человеко-ориентированный ИИ (HCAI)

Почему недостаточно просто «разработать ИИ»

На протяжении многих десятилетий развитие искусственного интеллекта рассматривалось в первую очередь как инженерная задача. Исследования концентрировались на алгоритмах, моделях, вычислительной эффективности, способности систем к обучению и обобщению. Главной метрикой «успеха» считалась точность модели, измеряемая на тестовой выборке. В рамках такой парадигмы предполагалось, что если система демонстрирует высокий уровень точности или классификационной силы, то она по определению полезна, применима и эффективна. Однако с развитием практического применения ИИ, особенно в пользовательских и социально чувствительных сферах — от медицины до образования и социальных сетей — стало очевидно, что алгоритмическая эффективность не гарантирует качество взаимодействия с человеком.

Иными словами, разработать работающий ИИ — это необходимое, но не достаточное условие создания полезной, безопасной и этичной интеллектуальной системы.

I. Алгоритмическая корректность ≠ пользовательская приемлемость

Интеллектуальная система может формально выполнять задачу, но оставаться для пользователя:

— непонятной — её поведение будет казаться случайным или не поддающимся объяснению;

— непредсказуемой — человек не сможет интерпретировать, когда и как сработает тот или иной механизм;

— неконтролируемой — пользователь не ощущает возможности влиять на результат или отменить решение;

— неприемлемой — модель может воспроизводить или усиливать дискриминационные паттерны, даже если это отражает «реальные» данные.

Типичный пример — алгоритмы рекомендаций, применяемые в социальных сетях или маркетплейсах. Даже если они эффективно повышают engagement и кликабельность, пользователь может чувствовать тревожность, потерю контроля, снижение автономии принятия решений, что приводит к эмоциональному выгоранию и цифровому отторжению.

II. Проблема ментальной модели и когнитивного разрыва

Одной из важнейших проблем взаимодействия человека с ИИ является несоответствие между реальной логикой работы модели и ментальной моделью пользователя — то есть тем, как человек думает, что система работает. Если пользователь не может предсказать поведение системы или объяснить себе её действия, возникает ощущение хаоса и фрустрации. Такое состояние известно в когнитивной психологии как когнитивный разрыв (cognitive dissonance или breakdown of sensemaking).

Когнитивные модели взаимодействия, начиная с концепций Дональда Нормана (Norman, 1986), подчеркивают важность предсказуемости и объяснимости интерфейсов. Когда же в системе действует обучаемая модель, поведение которой зависит от скрытых признаков, распределений и вероятностных предсказаний, пользователь оказывается в ситуации, где интерфейс видим, а логика — нет.

Таким образом, ИИ может функционировать «правильно» по техническим критериям, но быть непригодным для реального пользователя без поддержки когнитивной прозрачности.

III. Игнорирование этики, эмоций и восприятия

Системы, разработанные без учёта эмоциональных реакций, поведенческих паттернов, социальной справедливости или культурных особенностей, могут приводить к последствиям, несовместимым с этическими и правовыми нормами.

Так, система автоматического распределения социальных пособий, внедрённая в Нидерландах в 2019 году, использовала ИИ для прогнозирования вероятности мошенничества на основе демографических и поведенческих признаков. Модель была «эффективна», но нарушала принцип справедливости, поскольку дискриминировала по происхождению, району проживания и типу семьи. В итоге программа была отменена, а правительство принесло официальные извинения.

Этот кейс наглядно показывает, что формально корректная работа ИИ может нарушать базовые принципы прав человека, если не учитывать контекст взаимодействия, восприятие пользователя и социальную ответственность.

IV. Автоматизация без дизайна взаимодействия = потеря контроля

Во многих системах с ИИ наблюдается тенденция к «скрытой автоматизации» — то есть переходу от явно управляемых пользователем интерфейсов к системам, в которых алгоритмы принимают решения автономно и без объяснений. Такие интерфейсы уменьшают участие человека, но одновременно снижают доверие и разрушают пользовательскую агентность — ощущение, что человек способен действовать осознанно и по собственной инициативе.

Иными словами, автоматизация без сопровождения объяснений, обратной связи, возможности редактирования или отмены приводит к ощущению отчуждённости: пользователь становится пассивным наблюдателем, а не участником процесса.

V. Неразвитость UX-слоя в AI-системах как системная проблема

Большинство ИИ-платформ разрабатываются техническими командами, сфокусированными на точности моделей и производительности. В результате:

UX-дизайн внедряется на финальных этапах, в виде интерфейсной «обёртки»;

Обратная связь от пользователя не включена в петлю обучения модели;

Оценка качества ограничивается метриками (F1, precision, recall), не учитывающими восприятие и интерпретируемость;

Поведенческая аналитика воспринимается как второстепенная.

Это приводит к парадоксам: технологически сложные системы оказываются недоступными, тревожными или неприемлемыми для пользователей. Даже при наличии ресурсоёмких архитектур, дорогостоящих моделей и технической реализации, продукт может провалиться из-за отсутствия понимания человеческого фактора.

Сегодняшний этап развития ИИ требует не только прорывов в моделировании, но и переноса центра внимания с алгоритма на взаимодействие. Human-Centered AI (HCAI) предлагает фундаментальный сдвиг:

— от архитектур к контексту использования,

— от точности к объяснимости,

— от автономии к контролю,

— от поведения машины к переживанию человека.

Это не отказ от ИИ, а интеграция его возможностей в структуру человеческой деятельности — осмысленно, прозрачно и безопасно. Только при таком подходе интеллектуальные технологии смогут не просто работать, а быть принятыми, понятными и полезными в повседневной жизни.

Нарушенное доверие как следствие ошибок взаимодействия

Один из фундаментальных ресурсов, на которых строится успешное использование интеллектуальных систем, — это доверие пользователя. В отличие от традиционных программных продуктов, в которых поведение системы строго детерминировано и предсказуемо, искусственный интеллект действует в условиях неопределённости: он обучается на данных, принимает вероятностные решения, и его поведение может меняться в зависимости от контекста, новых входных данных или даже обновлений модели. Это делает взаимодействие с ИИ принципиально более хрупким: как только пользователь сталкивается с решением, которое он не может объяснить, обоснованно интерпретировать или предсказать, он начинает терять уверенность в системе.

Доверие формируется не на основании технической корректности, а через восприятие. Пользователь ожидает, что система будет действовать понятно, справедливо, логично и — при необходимости — под его контролем. Когда интерфейс не объясняет, почему была сделана та или иная рекомендация, или когда система действует вопреки ожиданиям пользователя, происходит нарушение ментальной модели взаимодействия. Человек ощущает, что ИИ ведёт себя «сам по себе», игнорирует его намерения и контекст. Это приводит к тому, что система воспринимается как неконтролируемая, а в ряде случаев — как враждебная.

Типичный пример — рекомендательные алгоритмы. Пользователь заходит в приложение, чтобы получить один тип контента, а система на основе истории поведения начинает навязчиво продвигать другую тему. С точки зрения модели — всё логично: вероятностный прогноз построен, система «учится». Но для человека это выглядит как вторжение или непонятное навязывание. Возникает ощущение: «меня не слышат», «мне не объясняют», «я не понимаю, что происходит». Даже при технически корректной работе модели теряется ощущение безопасности и управляемости — критически важные элементы доверия.

Особое внимание заслуживает поведение систем в ситуациях с высоким уровнем stakes — когда от решения зависят здоровье, финансы или личная информация. Например, если медицинская ИИ-система предлагает план лечения, не сопровождая это объяснением, пациент или врач могут отказаться от её использования. Точно так же, если финансовый алгоритм отклоняет заявку на кредит без понятного комментария, клиент будет воспринимать это как произвол. Даже если система действует в рамках правил, отсутствие объяснения делает её неприемлемой.

Интересно, что пользователи в этих случаях не обязательно требуют полного понимания внутренней логики модели. Глубокие технические детали — как правило, неинтересны или недоступны неспециалисту. Но крайне важно, чтобы система предоставляла понятные, когнитивно интерпретируемые объяснения — метафоры, аналогии, причинно-следственные связи, визуализации — позволяющие выстроить ментальную модель происходящего.

Потеря доверия часто проявляется не в явных жалобах, а в поведенческой реакции: снижении вовлечённости, отказе от функций, переключении на альтернативы. В долгосрочной перспективе это подрывает саму идею использования ИИ как вспомогательной технологии. Люди перестают ощущать, что ИИ работает с ними — и начинают воспринимать его как автономный, отчуждённый, непонятный элемент в системе.

Проблема ещё более усугубляется тем, что большинство UX-проектов с ИИ по-прежнему сосредоточены на дизайне визуальных слоёв, а не на когнитивной структуре доверия. Интерфейс может быть стилистически современным, но не предоставлять ничего для построения надёжной модели взаимодействия. В результате, система, вложенная в современный UI, может оставаться «чёрным ящиком» в глазах пользователя.

Это приводит нас к необходимости переосмысления роли UX в ИИ: не как оболочки, а как архитектуры объяснения, поддержки, управления и диалога. Именно этот переход и задаёт основное направление Human-Centered AI.

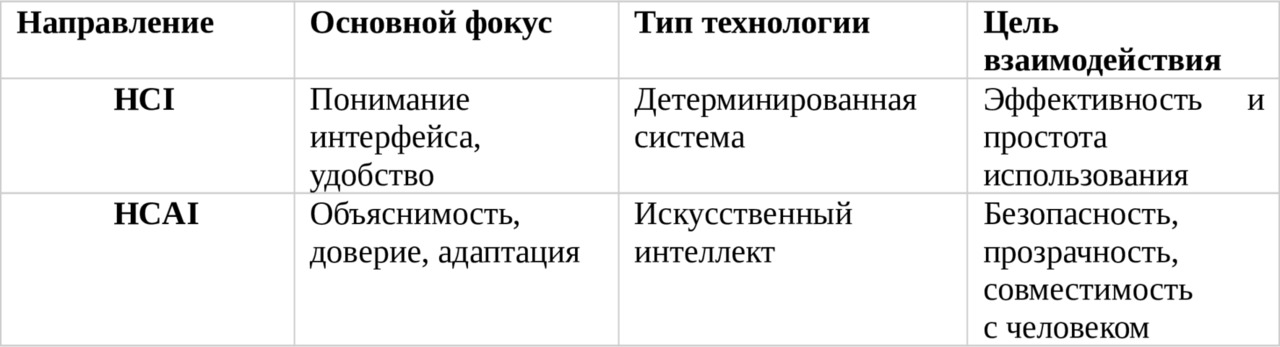

Понятия HCI и HCAI: история и различия

Human-Computer Interaction (HCI) — это область, изучающая проектирование, реализацию и оценку взаимодействия между людьми и компьютерными системами. Термин появился в 1980-х годах на стыке когнитивной психологии, эргономики и инженерии интерфейсов, когда стало очевидно, что эффективность цифровых систем зависит не только от их вычислительных характеристик, но и от того, насколько хорошо они соотносятся с ментальными, сенсорными и моторными возможностями пользователя.

На ранних этапах HCI фокусировалась на юзабилити (usability): понятности, простоте, скорости выполнения задач. Однако с 2000-х годов область стала включать в себя также эмоциональные, поведенческие и контекстные аспекты взаимодействия, превратившись в мультидисциплинарное поле, включающее элементы психологии, лингвистики, дизайна, информатики и социальной теории.

Современное определение HCI можно сформулировать следующим образом:

Human-Computer Interaction — это исследование и практика проектирования технологий, которые адаптированы к возможностям, потребностям и ограничениям человека, с целью обеспечения эффективного, осмысленного и безопасного взаимодействия.

Важным в этом определении является акцент на человеке как активном участнике, а не просто пользователе. Поведение, ожидания, навыки и контекст использования становятся не побочными факторами, а центральными точками проектирования.

Переход к HCAI: от взаимодействия к ответственности

Появление искусственного интеллекта как активного компонента взаимодействия привело к необходимости расширить рамки HCI. Когда система начинает самостоятельно адаптироваться, обучаться на пользовательских данных и предлагать решения, возникает новая степень сложности: взаимодействие приобретает черты социального, неопределённого и потенциально автономного поведения. В этом контексте взаимодействие перестаёт быть только вопросом интерфейса — оно становится вопросом влияния, доверия, прозрачности и справедливости.

Так появляется направление Human-Centered AI (HCAI) — ответ на вызов: как сделать ИИ не просто функциональным, а понятным, полезным и этически допустимым для человека. В отличие от HCI, где взаимодействие строится с детерминированной системой, HCAI работает с системами, поведение которых изменчиво, вероятностно и не всегда поддаётся контролю извне.

В этом смысле, HCAI — это не просто «интерфейс для ИИ», а архитектура взаимодействия, где ИИ встроен в жизненный, социальный и поведенческий контекст человека.

Классическая модель взаимодействия: цикл Нормана

Один из самых влиятельных вкладов в HCI — модель взаимодействия, предложенная Дональдом Норманом (D. Norman, The Design of Everyday Things, 1988). Эта модель объясняет когнитивную структуру взаимодействия между человеком и системой, разбивая её на логические стадии, которые проходят в голове пользователя при выполнении задачи.

Норман выделяет два ключевых цикла:

Гульфа исполнения (Gulf of Execution) — разрыв между намерением пользователя и тем, как это реализуется в системе;

Гульфа оценки (Gulf of Evaluation) — разрыв между тем, что система делает, и тем, как пользователь это воспринимает.

На практике модель описывается как семишаговая когнитивная петля:

1. Формирование цели — что пользователь хочет достичь

2. Формирование намерения — какой план действия нужен

3. Определение последовательности действий — что нажать, выбрать

4. Физическое выполнение действия — ввод, клик, жест

5. Наблюдение за результатами — система выдаёт ответ

6. Интерпретация вывода — что это значит?

7. Оценка состояния системы — всё ли пошло по плану?

Эта модель применима и к простым интерфейсам (например, банкомат), и к сложным ИИ-системам. Однако в случае с ИИ добавляется новая проблема: система может менять поведение в зависимости от данных, адаптироваться, принимать решения автономно. Это означает, что даже при чётком исполнении команды результат может отличаться от ожидаемого, а этапы 5–7 (наблюдение, интерпретация, оценка) становятся ключевыми точками возможного срыва доверия.

Актуальность модели Нормана в эпоху ИИ

В контексте HCAI модель Нормана приобретает новое измерение. Её важность возрастает, потому что именно на стадии оценки поведения ИИ пользователь сталкивается с трудностью: результат может быть корректным математически, но не соответствовать ментальной модели. Это требует от системы не просто интерфейса, а активного участия в объяснении логики своих действий — например, через визуализацию причин, акцентов, уверенности, альтернатив.

Взаимодействие больше не замыкается в схеме «команда–ответ», а превращается в диалог, в котором ИИ должен не только реагировать, но и прозрачно коммуницировать ход своей «мысли».

Как HCAI расширяет HCI: включение машинного обучения, этики и доверия

Системы взаимодействия между человеком и компьютером в рамках классической парадигмы HCI предполагают, что поведение системы определено заранее. Архитектура интерфейса проектируется под жёстко заданные функции, а результат действия пользователя может быть точно предсказан разработчиком. Однако с появлением и активным внедрением систем искусственного интеллекта, в частности машинного обучения (ML), данное допущение более не работает.

ИИ-модели — особенно обучаемые — обладают рядом характеристик, которые принципиально нарушают базовые предпосылки классической HCI. Среди таких характеристик:

Обучение на данных (а не программирование поведения вручную);

Непредсказуемость решений в отдельных случаях (особенно при генеративных или вероятностных выходах);

Адаптация во времени — модель может обновлять внутренние параметры и поведение;

Необъяснимость логики вывода без дополнительной интерпретации.

Это порождает качественно новые задачи, которых не было в традиционной HCI:

Как представить поведение модели так, чтобы оно было понятно человеку?

Как сделать выводы модели интерпретируемыми без глубоких технических знаний?

Как оценить, безопасна ли система для разных типов пользователей?

Как удостовериться, что поведение ИИ не приводит к дискриминации, манипуляции или психологическому дискомфорту?

Эти вопросы формируют обоснование перехода от HCI к Human-Centered AI (HCAI) — более широкому подходу, который включает в повестку не только дизайн интерфейса, но и:

Интеграцию методов машинного обучения в пользовательский контекст. ML-модели требуют новых форм визуализации, настройки и взаимодействия:

1. Пользователь должен понимать, на основе каких данных сделан вывод;

2. Необходимо отображать уровень уверенности модели, а не просто результат;

3. Интерфейс должен предлагать альтернативные варианты, позволяя сравнивать решения.

В результате проектирование HCAI включает в себя XAI-практики (Explainable AI): объяснимость решений, визуальные метафоры, комментарии модели, причинно-следственные графы. Это требует от дизайнеров и исследователей не только навыков UX, но и понимания поведения обучаемых моделей.

Этика и социальная ответственность как часть дизайна

Классическая HCI в меньшей степени касалась нормативных или этических вопросов. Система рассматривалась как инструмент, нейтральный по определению. Однако ИИ, в силу своей способности усиливать предвзятость, воспроизводить структурное неравенство и действовать вне прозрачного алгоритма, требует включения этики как обязательного проектного уровня.

Это означает:

— необходимость оценивать справедливость алгоритма по отношению к разным социальным группам;

— учитывать последствия автоматизированных решений для конкретных категорий пользователей;

— обеспечивать обратную связь и возможность пересмотра или отмены решений ИИ;

— внедрять принципы responsibility-by-design — ответственность за результат не только после внедрения, но и на этапе проектирования.

В рамках HCAI эти аспекты превращаются из «желательных» в структурно необходимых.

Доверие как инженерная и психологическая категория

В HCI доверие к интерфейсу основывалось на стабильности, скорости, понятности. В HCAI доверие к системе включает гораздо более широкий спектр факторов:

Понимает ли пользователь, как система принимает решения?

Может ли он предсказать поведение ИИ в нестандартной ситуации?

Чувствует ли он, что может контролировать результат?

Есть ли у него возможность оспорить автоматическое действие?

Ощущает ли он, что система учитывает его интересы, а не просто оптимизирует метрику?

Таким образом, доверие становится центральной проектной переменной. Его нельзя «добавить» на финальном этапе. Оно должно быть интегрировано в архитектуру поведения системы, а также поддерживаться через объяснения, прозрачность, управление ожиданиями и понятный интерфейс.

HCAI не противопоставляется HCI, а дополняет и расширяет его, адаптируя классические методы к новым вызовам, связанным с:

— вероятностной природой ИИ,

— непредсказуемыми последствиями автоматизации,

— необходимостью верификации и объяснения логики модели,

— учётом социальных, правовых и эмоциональных последствий.

Если HCI — это проектирование взаимодействия с интерфейсом, то HCAI — это проектирование совместной деятельности человека и ИИ, в которой важно не только, что делает машина, но и как это воспринимается, понимается и используется человеком.

Этапы развития пользовательских интерфейсов

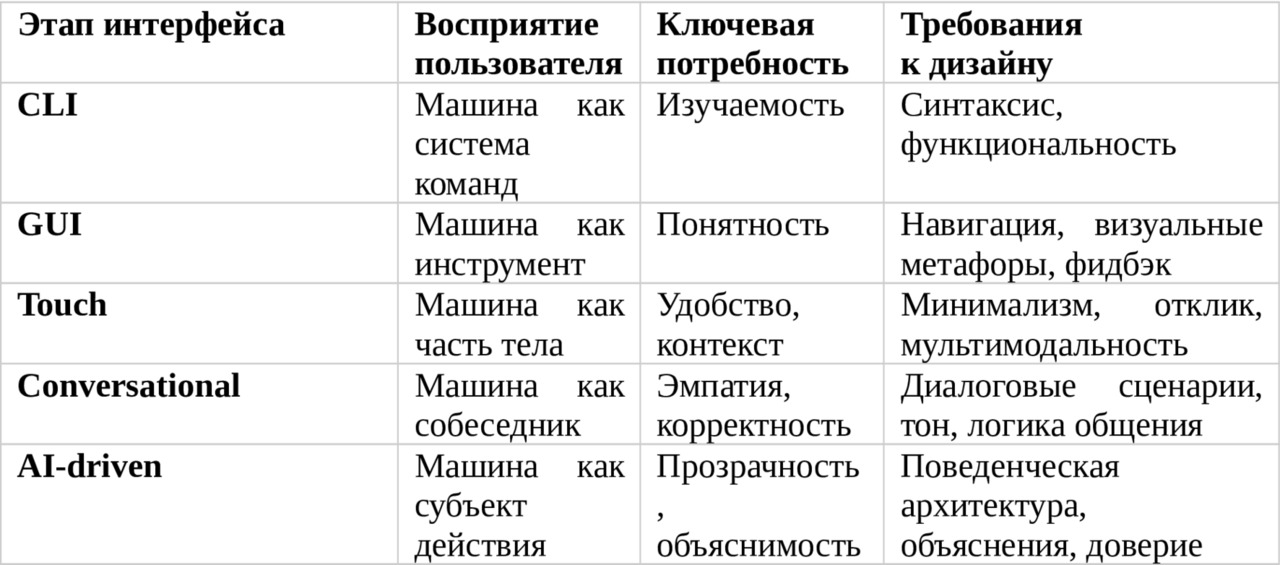

Эволюция интерфейсов: от CLI до AI-driven UX

Современные технологии взаимодействия между человеком и цифровыми системами представляют собой результат многолетней эволюции. На каждом этапе — от командной строки до интеллектуальных систем — менялась не только форма интерфейса, но и сама природа взаимодействия, а вместе с ней — ожидания пользователя, когнитивная нагрузка, дизайнерские задачи и принципы проектирования. Понимание этой эволюции необходимо для осознания, почему появление HCAI — не просто технологический тренд, а логическая необходимость следующего поколения взаимодействия.

I. CLI — Command Line Interface (1970–1980-е годы)

Характеристики:

— Взаимодействие через текстовые команды;

— Пользователь должен помнить синтаксис и параметры;

— Минимальная визуальная обратная связь;

— Высокий порог входа, низкий уровень интуитивности.

Восприятие пользователя:

— Интерфейс воспринимался как «язык машины», требующий изучения;

— Пользователь чувствовал себя «гостем» в системе: допуск к вычислению — через знание;

— Отсутствие визуальных ориентиров означало высокую когнитивную нагрузку.

Дизайнерские задачи:

— Были минимальными: дизайн «интерфейса» сводился к логике команд;

— Основной акцент — на документации и логике командной оболочки;

— UX в современном понимании отсутствовал — взаимодействие рассматривалось как программирование.

CLI дал пользователю доступ к мощным функциям, но требовал навыков. Он не адаптировался к человеку — человек адаптировался к машине.

II. GUI — Graphical User Interface (1980–2000)

Характеристики:

— Метапафоры (папки, окна, иконки), визуальное представление команд;

— Взаимодействие через мышь, меню, кнопки;

— Низкий когнитивный порог: система говорит на «языке пользователя».

Восприятие пользователя:

— Резкий рост доступности: компьютеры стали восприниматься как инструмент, а не как терминал;

— Пользователь ориентируется визуально, не запоминая команд;

— Интерфейс стал самодокументируемым: подсказки, визуальные иерархии, affordances.

Дизайнерские задачи:

— Проектирование стало мультимодальным: требовалось учитывать композицию, поведение, метафору;

— Появился UX как дисциплина: usability, тестирование, паттерны взаимодействия;

— Центром взаимодействия стал экран — визуальная плоскость управления.

GUI впервые поставил пользователя в центр проектирования. Машина стала адаптироваться к человеку — через метафору, визуальный язык, интерактивность.

III. Touch и Mobile-first интерфейсы (2007–н.в.)

Характеристики:

— Сенсорный ввод, жесты, отсутствие традиционного курсора;

— Экран = интерфейс; ограниченное пространство, контекстность;

— Взаимодействие в движении, с одной рукой, в социальных ситуациях.

Восприятие пользователя:

— Пользователь ожидает интуитивности и мгновенного отклика;

— Интерфейс воспринимается как «естественный» — нет барьеров мышления;

— Повышенная чувствительность к задержке, точности, реактивности.

Дизайнерские задачи:

— Создание минималистичных, адаптивных интерфейсов с высокой плотностью смысла;

— Учет физиологических и социальных ограничений: размер пальца, освещение, отвлекающие факторы;

— Разработка UX-паттернов, адаптированных под касание (tap targets, gestures).

Мобильные интерфейсы усилили контекстное взаимодействие — пользователь ждёт, что система «понимает», где он, когда, с каким намерением и в каком состоянии.

IV. Conversational UI — голосовые и чат-интерфейсы (2015–н.в.)

Характеристики:

— Взаимодействие через диалог: голосом или текстом;

— Отказ от традиционной визуальной навигации;

— Сильная зависимость от NLP и диалоговой логики.

Восприятие пользователя:

— Система воспринимается как собеседник, а не как программа;

— Возникает иллюзия агентности: «у ИИ есть намерения»;

— Повышенное ожидание эмоциональной и контекстной адекватности.

Дизайнерские задачи:

— Проектирование сценариев, интентов, ответов, тона и логики общения;

— Учет вариативности языка, синтаксиса, ошибок пользователя;

— Работа с ожиданиями: «ИИ понимает меня» — «ИИ отвечает правильно».

Conversational UI требует когнитивного моделирования поведения ИИ, а не просто навигации по функциям. Пользователь ждёт эмпатии, адаптивности, персонализации.

V. AI-driven UX — интеллектуальные адаптивные интерфейсы (2020+)

Характеристики:

— ИИ определяет содержание, структуру, логику интерфейса в реальном времени;

— Система обучается на действиях пользователя, строит прогнозы, адаптирует поведение;

— Пример: рекомендательные системы, персонализированные интерфейсы, умные ассистенты.

Восприятие пользователя:

— Пользователь всё чаще не понимает, почему система ведёт себя определённым образом;

— Возникает ощущение автономности — система действует «сама»;

— Повышаются риски когнитивного дискомфорта, недоверия, выученной беспомощности.

Дизайнерские задачи:

— Не просто проектировать интерфейс, а проектировать поведение ИИ;

— Внедрять объяснимость, визуализацию логики, доверительные механизмы;

— Создавать петлю обратной связи: пользователь влияет на систему, система объясняет себя.

AI-driven UX требует перехода от дизайна интерфейса к архитектуре взаимодействия с интеллектуальной системой. Это уже не интерфейс в классическом смысле — это проектирование цифрового поведения.

Как каждый этап изменил восприятие и требования к дизайну

Эволюция интерфейсов — это не просто изменение формы взаимодействия. Это постепенное усложнение роли системы в когнитивной экосистеме пользователя. От инструмента — к посреднику. От визуального слоя — к цифровому поведению. От кнопок — к рекомендациям. И вместе с этим меняется сам UX: от юзабилити к доверительному, прозрачному и контекстному взаимодействию, где ИИ не просто делает, а объясняет, адаптируется, слушает и учитывает человека.

Именно здесь начинается зона ответственности HCAI — следующей стадии в развитии взаимодействия. Не дизайна кнопок, а дизайна отношений между человеком и интеллектуальной системой.

Зачем нужен HCAI: от автоматизации к осмысленному взаимодействию

По мере того, как искусственный интеллект становится активным элементом пользовательского опыта, сама суть взаимодействия между человеком и системой меняется. ИИ больше не просто технический компонент, обрабатывающий данные на заднем плане. Он становится медиатором реальности — предлагает, фильтрует, оценивает, принимает решения, заменяет выбор. Это приводит к сдвигу в роли интерфейса: если ранее интерфейс «открывал» функции, то теперь он становится точкой входа в логику поведения автономной системы. Именно в этом контексте возникает необходимость в человеко-ориентированном подходе к ИИ — HCAI.

ИИ без человека: пример алгоритмов TikTok и YouTube

Алгоритмические рекомендательные системы — одна из самых масштабных и заметных форм внедрения ИИ в повседневную жизнь. Алгоритм YouTube, как и TikTok For You Feed, строится на непрерывном сборе и анализе пользовательских сигналов: история просмотров, продолжительность просмотра, лайки, пропуски, повторы. Модель обучается на миллиардах взаимодействий и формирует персонализированную ленту рекомендаций, оптимизированную под удержание внимания.

Формально система достигает поставленной метрики — максимизации вовлечённости. Но при этом у пользователя отсутствует возможность:

— понять, почему он видит тот или иной контент;

— изменить принципы работы рекомендации;

— отключить или корректно перенацелить поведенческий профиль.

В результате пользователь теряет ощущение контроля. Контент кажется «навязанным», а поведение системы — непрозрачным. Это приводит к недоверию, усталости, ощущению цифрового давления, особенно в случаях, когда система фиксирует кратковременные сигналы (например, случайный клик на тревожное видео) и превращает их в устойчивый паттерн рекомендаций.

В случае TikTok это особенно заметно: поведенческий профиль формируется за считанные минуты, но не объясняется, не визуализируется, не редактируется. Алгоритм работает «через пользователя», но без диалога с ним.

Почему автоматизация без обратной связи — это риск

Автоматизация становится опасной тогда, когда она отменяет обратную связь. В классической HCI обратная связь (feedback) — один из базовых принципов юзабилити: пользователь должен видеть, что произошло после действия. В AI-системах это правило часто нарушается: поведение модели адаптивно, но не сопровождается комментариями, не подлежит корректировке, не даёт возможности объяснить логику вывода.

Когда пользователь не понимает, как повлиять на поведение системы — он либо прекращает использовать её, либо теряет доверие, считая модель манипулятивной или «живущей своей жизнью».

Пример из UX-аналитики: пользователи умных колонок с голосовыми ассистентами (Siri, Google Assistant) часто перестают использовать функции, если первые 1–2 взаимодействия приводят к неадекватным или непонятным результатам. Причина — отсутствие объяснения ошибок, непрозрачность «мысленного процесса» ИИ и невозможность корректировки запроса.

Роль UX и поведенческой аналитики в предотвращении проблем

HCAI строится на признании того, что поведение системы должно проектироваться с учётом восприятия, эмоций, ожиданий и реакций пользователя. UX в этом контексте — не визуальный слой, а когнитивная инфраструктура: через неё человек осмысливает, прогнозирует и влияет на поведение ИИ.

Поведенческая аналитика в HCAI отвечает за:

— сбор данных об эмоциях, вовлечённости, фрустрации, уровне доверия;

— интерпретацию паттернов поведения: что пользователь делает, чего избегает, что вызывает тревожность;

— формирование метрик доверия и прозрачности, а не только эффективности (например: perceived control, cognitive effort, satisfaction with agency).

Используя эти данные, можно корректировать поведение моделей: не только улучшать метрики CTR, но и снижать психологическое сопротивление, увеличивать понимание и формировать чувство контроля у пользователя.

Этика, доверие и инклюзия как проектные параметры

Когда система ИИ вступает в контакт с человеком, она не может быть нейтральной. Любая модель обучается на данных, которые отражают реальные искажения: социальные, поведенческие, экономические. В результате:

— алгоритм может непреднамеренно усиливать дискриминацию;

— недоверие может возрастать у маргинализированных групп, которые не распознают себя в логике модели;

— система может оказаться недоступной по когнитивным, языковым или физическим причинам.

Инклюзивность, справедливость и прозрачность в HCAI — не абстрактные ценности, а функциональные свойства системы, от которых зависит принятие технологии обществом.

Например, в образовательных системах ИИ, предлагающих персонализированные рекомендации студентам, крайне важно:

— объяснять, почему предложен тот или иной трек;

— учитывать индивидуальные стили обучения;

— не усиливать предвзятости, связанные с оценками или демографией;

— предоставлять инструменты для изменения траектории.

Эти требования не входят в «техническое ТЗ» модели. Они возникают на уровне взаимодействия — и именно UX и поведенческая аналитика HCAI обеспечивают их реализацию.

HCAI — это не про «удобство»

Одно из ключевых недоразумений при интерпретации HCAI — это сведение его к теме удобства использования (usability). Хотя юзабилити остаётся важной частью взаимодействия, в центр HCAI ставится не удобство, а осмысленность, безопасность и адаптивность системы.

Удобство — это локальная характеристика: легко ли совершить действие.

Адаптивность и прозрачность — это системные свойства:

1. насколько система поддерживает пользователя в достижении целей,

2. насколько она корректно реагирует на изменения контекста,

3. может ли человек сохранять автономию, когда система берёт инициативу.

Долговременное взаимодействие возможно только тогда, когда ИИ не отнимает у человека право на интерпретацию и участие, а помогает ему лучше понять ситуацию, расширить выбор и сохранить чувство субъектности.

ключевые термины главы 1

Human-Computer Interaction (HCI) — Область, изучающая проектирование и оценку взаимодействия между человеком и компьютерными системами с целью повышения удобства, эффективности и понятности.

Human-Centered AI (HCAI) — Подход к разработке систем ИИ, фокусирующийся на прозрачности, объяснимости, контролируемости, доверии и социальной ответственности перед пользователем.

CLI (Command Line Interface) — Тип интерфейса, в котором взаимодействие происходит через ввод текстовых команд. Требует знания синтаксиса и логики командной оболочки.

GUI (Graphical User Interface) — Интерфейс с графическими элементами (окна, кнопки, иконки), делающий взаимодействие визуальным и более доступным.

Touch Interface — Сенсорный интерфейс, использующий жесты и касания, особенно распространённый в мобильных устройствах.

Conversational UI — Интерфейсы, основанные на диалоге с пользователем — текстовом или голосовом, часто с применением NLP.

AI-driven UX — Пользовательский опыт, управляемый ИИ — адаптивный, персонализированный, формируемый с помощью обучаемых моделей.

Usability — Показатель удобства системы: насколько она проста в освоении, эффективна в использовании и удовлетворяет потребности пользователя.

User Experience (UX) — Совокупность восприятий, реакций, эмоций и поведенческих паттернов пользователя при взаимодействии с системой.

Cognitive Load — Объём умственных усилий, который человек тратит на выполнение задачи или понимание интерфейса.

Explainability (XAI) — Способность ИИ-системы объяснить логику своих решений так, чтобы это было понятно человеку.

Transparency — Степень открытости алгоритма и интерфейса: насколько пользователь может понять, как работает система.

Bias (Алгоритмическая предвзятость) — Непреднамеренное смещение или дискриминация в алгоритмах, возникающие из-за перекосов в данных или структуре модели.

Fairness — Принцип справедливости: система должна принимать решения, не нарушая равенство возможностей между пользователями.

Ментальная модель — Внутреннее представление пользователя о том, как работает система. Чем ближе она к реальной логике — тем лучше UX.

Gulf of Execution / Evaluation — Расстояние между намерением пользователя и возможностями интерфейса (execution) и между результатом и его интерпретацией (evaluation), согласно модели Нормана.

Trust — Уверенность пользователя в корректной, честной и предсказуемой работе системы ИИ.

Controllability — Возможность пользователя влиять на поведение ИИ, отменять или уточнять его действия.

Responsibility-by-Design — Подход, при котором принципы ответственности, прозрачности и объяснимости закладываются на этапе проектирования, а не «добавляются» постфактум.

Agency (агентность) — Способность пользователя действовать осознанно и автономно при взаимодействии с системой. В HCAI задача — её сохранить.

Behavioral Pattern — Поведенческий шаблон, отражающий типичную реакцию или выбор пользователя в определённой ситуации.

Adaptive System — Система, которая подстраивается под пользователя на основе данных, поведения или внешнего контекста.

Глава 2. Психология пользователя в HCAI

Когнитивные основы пользовательского взаимодействия с интеллектуальными системами

Проектирование взаимодействия между человеком и системой — это не только вопрос интерфейса, визуальной эстетики или структуры сценариев. Взаимодействие с ИИ задействует ключевые когнитивные механизмы: восприятие, внимание, кратковременную и долговременную память, а также процессы интерпретации и принятия решений. Если эти механизмы не учитываются, система может быть технически корректной, но когнитивно — избыточной, перегруженной, непонятной. В контексте HCAI этот вопрос становится особенно критичным: ИИ-системы не просто реагируют, они инициируют действия, прогнозируют, предлагают, управляют контекстом. А значит, они вступают в прямое взаимодействие с ментальными процессами пользователя.

Когнитивная нагрузка: ресурсный предел мышления

Когнитивная нагрузка (cognitive load) — это объём ментальных ресурсов, который требуется человеку для обработки информации, принятия решения или выполнения действия. Этот термин был введён в рамках когнитивной психологии и педагогики (Sweller, 1988), но быстро стал центральным понятием в UX-дизайне.

Когнитивная нагрузка возникает всегда, когда:

— интерфейс требует усилий для навигации;

— система предлагает несколько опций без явной иерархии;

— результат действия неясен, и требуется дополнительное мышление для интерпретации;

— отсутствует прямая связь между целью и способом её достижения.

Для ИИ-интерфейсов характерны особые источники когнитивной нагрузки:

1. Обилие вероятностных выводов без явных оснований.

2. Персонализация без объяснения принципов.

3. Автоматизация, не отражённая визуально или логически.

4. Скрытая адаптация, создающая ощущение нестабильности.

Если пользователь не может удерживать в кратковременной памяти текущие действия, правила, логику поведения системы — возникает фрустрация. Особенно опасна когнитивная перегрузка, при которой пользователь теряет способность принимать рациональные решения, ориентироваться в интерфейсе и, в конечном итоге, отказывается от взаимодействия.

UX-задача HCAI в этом контексте — минимизировать когнитивную нагрузку без потери функциональной мощности системы. Это достигается через понятные сценарии, иерархию информации, визуальное подтверждение действия, использование ментальных моделей пользователя и поддержку кратковременной памяти.

Внимание: распределение ресурсов в условиях перегрузки

Внимание — это ограниченный когнитивный ресурс, распределяемый между стимуляцией, задачами и источниками информации. В условиях ИИ-взаимодействия внимание становится критически важным, потому что:

— интеллектуальная система может инициировать действия без запроса;

— интерфейс может меняться динамически в зависимости от поведения пользователя;

— рекомендации могут конкурировать за внимание (например, push-уведомления, адаптивные блоки контента).

Психология внимания указывает на несколько свойств, актуальных для HCAI:

— избирательность: пользователь замечает только то, что имеет когнитивную значимость;

— ограниченность: невозможно удерживать внимание более чем на 4–7 элементах одновременно;

— подверженность искажению: внимание легко переключается на яркие, а не важные элементы.

ИИ-системы, действующие вне визуального контекста (например, голосовые помощники или автоматические триггеры), особенно рискуют нарушить восприятие внимания, потому что пользователь не ожидает действия, и не получает предупреждающего сигнала.

В UX-дизайне HCAI это требует строгого внимания к темпу, плотности и каналам подачи информации. Архитектура интерфейса должна поддерживать фокус, а не разрушать его.

Восприятие: преобразование интерфейса в смысл

Восприятие — это процесс преобразования сенсорных данных в осмысленные структуры. В UX этот процесс охватывает зрительные, звуковые, тактильные и временные характеристики интерфейса.

Особенности восприятия, критичные для HCAI:

Гештальт-принципы — пользователь группирует элементы по сходству, близости, симметрии.

Иллюзия причинности — человек склонен воспринимать последовательные события как связанные, даже если это не так.

Аффективное восприятие — эмоциональный отклик влияет на интерпретацию поведения системы.

ИИ-интерфейсы могут нарушать принципы восприятия следующим образом:

— изменяя поведение без видимых причин (например, адаптивный рейтинг);

— создавая иллюзию персонализированного понимания, в то время как это шаблон;

— скрывая внутренние связи между входными и выходными данными.

Если пользователь не может сопоставить стимул и результат, восприятие дезорганизуется. Он начинает чувствовать тревожность, раздражение или отрешённость. Особенно чувствительны к таким ошибкам пользователи с разной сенсорной или когнитивной доступностью: слабое зрение, сниженная концентрация, возрастные особенности.

В HCAI восприятие должно проектироваться как структура устойчивых, воспроизводимых смыслов, а не как реактивная визуализация. Это достигается через повторяемость, семиотику (иконы, цвета, формы), а также поясняющие микросценарии.

Память: ограничения и якоря взаимодействия

Кратковременная память (short-term memory) ограничена по объёму: согласно исследованиям Миллера, человек может удерживать от 5 до 9 единиц информации одновременно (магическое число 7 ± 2). При этом длительность хранения — около 15–30 секунд без повторения. В условиях цифрового взаимодействия это означает, что:

— пользователю сложно удерживать в памяти структуру диалога, особенно если он разветвлён;

— без визуальной поддержки или напоминания прошлые действия забываются;

— интерфейсы с несколькими вкладками, состояниями, вариантами вызывают когнитивную фрагментацию.

ИИ-системы добавляют сложности: адаптивность, нестабильность, вариативность. Если пользователь не получает подтверждения действий или напоминания о предыдущем шаге, память обрывается, и возникает эффект «перезапуска» — каждый новый экран ощущается как первый.

В HCAI необходимо:

— сохранять контекст: указывать, где находится пользователь и что уже было сделано;

— использовать прогресс-бары, чек-листы, breadcrumb-навигацию;

— напоминать пользователю об его собственных действиях (например: «Вы уже искали X»);

— минимизировать временные разрывы в логике.

Долговременная память (long-term memory) зависит от повторений, смысловых связей и эмоционального отклика. Поэтому особенно важны консистентность, повторяемость и поддержка мотивации в UX HCAI.

Модели принятия решений: рациональные и ограниченно-рациональные (Kahneman, Tversky)

Любое взаимодействие человека с системой — это не просто реакция на стимул, а серия микрорешений. Открыть приложение, нажать кнопку, принять рекомендацию ИИ, игнорировать уведомление, отказаться от действия — каждое из этих событий включает когнитивный акт выбора. Понимание того, как человек принимает решения в условиях неопределённости, ограниченного времени и информационной перегрузки, позволяет проектировать ИИ-системы, которые не только удобны, но и не искажают поведение, не манипулируют восприятием и не подрывают автономию пользователя.

HCAI опирается на модели поведенческой экономики и когнитивной психологии, в частности — на исследования Даниэля Канемана и Амоса Тверски, чьи работы заложили основу понимания того, как реальные люди принимают решения — не в идеальных условиях, а в сложной, эмоционально и когнитивно насыщенной среде.

Рациональная модель: Homo Economicus

В классических экономических и инженерных теориях долгое время доминировала модель рационального агента, или Homo Economicus. Согласно этой модели:

— человек принимает решения, стремясь максимизировать свою полезность;

— обладает полной информацией о вариантах;

— способен обрабатывать все альтернативы;

— действует логично и последовательно.

Применительно к интерфейсу это предполагало, что если система предложит пользователю наилучший выбор, тот его примет — при условии, что информация полная и подана ясно.

Однако многократно доказано, что в реальной жизни люди не действуют рационально:

— они не видят всех опций;

— не могут оценить вероятности;

— опираются на эвристики, интуицию, эмоции;

— искажают информацию и переоценивают риски.

Таким образом, рациональная модель — удобный, но неверный ориентир для проектирования ИИ-взаимодействия.

Ограниченная рациональность (bounded rationality): Г. Саймон

Герберт Саймон (H. Simon), один из первых критиков классической рациональности, ввёл понятие ограниченной рациональности. В его модели человек:

— стремится к приемлемому, а не к оптимальному решению (satisficing);

— работает с ограниченными когнитивными ресурсами;

— часто выбирает первое «достаточно хорошее» решение, а не лучшее из всех.

Для UX-дизайна это означает, что интерфейс должен:

1. снижать нагрузку на анализ;

2. предлагать адекватные подсказки и ориентиры;

3. помогать не в выборе, а в отказе от плохих вариантов.

ИИ в этом контексте должен не только подсказывать, но и учитывать, как именно пользователь принимает решения в условиях недостатка информации, времени и уверенности.

Эвристики и искажения (biases): Канеман и Тверски

Канеман и Тверски радикализировали представление о человеческом мышлении. Их модель двухсистемного мышления (двухсистемная модель — dual-system theory) предполагает существование:

— Система 1 — быстрое, автоматическое, эмоциональное мышление

— Система 2 — медленное, логическое, аналитическое мышление

Большинство пользовательских решений — особенно в цифровой среде — принимаются Системой 1, то есть интуитивно, под влиянием настроения, паттернов, первого впечатления.

Примеры типичных когнитивных искажений:

1. Эффект якоря (anchoring) — первая цифра или значение влияет на последующие оценки.

2. Эвристика доступности — пользователь оценивает вероятность события по тому, насколько легко он вспоминает подобный случай.

3. Иллюзия контроля — человек переоценивает своё влияние на случайные процессы.

4. Слепое следование рекомендациям (automation bias) — доверие машине выше, чем собственным суждениям, даже при наличии ошибок.

ИИ-интерфейсы усиливают эти эффекты, особенно если:

— рекомендации подаются без объяснения;

— визуальный приоритет даётся «правильному» варианту;

— отсутствует равновесие между вариантами;

— формулировки навязчиво позитивны («лучший выбор», «рекомендуемое»).

Таким образом, ИИ способен не только отражать, но и усиливать искажения, встроенные в человеческое мышление. Это накладывает этическую и когнитивную ответственность на проектирование интерфейса: не усиливать манипулятивные паттерны, а проектировать их с осознанием рисков.

Поведение под влиянием ограниченной информации

Цифровая среда представляет собой идеальный контекст для когнитивных искажений:

— пользователь не видит всей картины;

— действует быстро и фрагментарно;

— ИИ-система преподносит информацию в определённом порядке и форме.

Это формирует три ключевые задачи HCAI-дизайна:

1. Понимать, когда искажения естественны и избежать их невозможно.

2. Проектировать интерфейсы, которые минимизируют вред от таких искажений.

3. Использовать эвристики во благо: для поддержки пользователя, а не манипуляции.

Пример: вместо того чтобы показывать «рекомендуемое» видео без объяснений, система может добавить — «основано на ваших предыдущих интересах: A, B, C» — это снижает эффект слепого принятия и возвращает пользовательскую агентность.

Поведенческие эффекты ИИ — автоматизация, доверие, переоценка

ИИ-системы, особенно в потребительском сегменте, давно перестали быть просто вычислительными механизмами. Они стали участниками повседневных решений: от выбора маршрута до карьерных рекомендаций, от модерации контента до диагностики заболеваний. Это означает, что ИИ встраивается в поведенческий цикл пользователя, изменяя как логику действия, так и саму структуру выбора. Эти изменения могут быть нейтральными, поддерживающими — или искажающими, подрывающими агентность.

Проектирование ИИ, не учитывающее эти эффекты, рискует создать системы, которые будут работать правильно, но вести пользователя к ошибочным, зависимым или манипулятивным паттернам поведения. Именно поэтому поведенческий анализ — один из краеугольных элементов HCAI.

Автоматизация и её психологические последствия

Автоматизация — одна из целей ИИ, обещающая повышение эффективности, снижение затрат и скорости выполнения задач. Однако в поведенческом аспекте автоматизация может иметь обратные последствия, особенно если она внедряется без когнитивной или интерфейсной поддержки.

Классические эффекты автоматизации:

Automation complacency — снижение внимательности, когда система берёт на себя контроль (пример: автопилот).

Loss of skill — деградация навыков при регулярной делегации задачи ИИ.

Overtrust / automation bias — избыточное доверие к ИИ, даже при очевидных ошибках.

Undertrust — отказ от использования системы из-за одного сбоя (loss of trust recovery).

Важно понимать, что автоматизация влияет не только на результат, но и на восприятие контроля. Если пользователь не знает, что именно делает система, или не может отключить её поведение, возникает фрустрация, тревожность и ощущение бессилия. Это особенно критично в системах с высокой чувствительностью: финансы, здоровье, безопасность.

Доверие: не данность, а проектный результат

Доверие (trust) в контексте ИИ — это готовность пользователя принять решение, сделанное системой, как корректное и приемлемое. Это не эмоция, а когнитивная оценка надёжности, формируемая на основе:

— предсказуемости поведения ИИ;

— объяснимости его действий;

— согласованности с ментальной моделью пользователя;

— наличия возможности контроля или отмены.

HCAI рассматривает доверие как конструкцию, которую необходимо проектировать. Оно должно:

1. не быть абсолютным (overtrust может быть опасен);

2. формироваться постепенно (через сценарии, поведение, объяснения);

3. быть устойчивым к единичным сбоям (механизмы восстановления доверия).

Нарушение доверия происходит в ситуациях, когда:

— ИИ даёт непредсказуемый или неадекватный результат;

— поведение системы меняется без сигнала;

— отсутствует объяснение того, что произошло.

Задача дизайна в HCAI — создать условия, в которых поведение системы будет:

— предсказуемым в своей непредсказуемости;

— объяснимым при необходимости;

— контролируемым, с возможностью вмешательства пользователя.

Переоценка и ложное впечатление интеллекта

ИИ — это не только функция, но и форма. Люди склонны приписывать системам намерения, сознание, мотивацию даже тогда, когда их нет. Это называется антропоморфизмом ИИ.

Поведенческие следствия:

Иллюзия понимания: пользователь думает, что ИИ «его понял», когда на самом деле сработал паттерн.

Персонализация без индивидуализации: пользователь считает, что система учитывает его контекст, хотя используется шаблон.

Эмоциональная привязанность: привлечение внимания, доверие или зависимость от генеративных агентов, особенно в чат-формате (пример: Replika).

Переоценка ИИ — особенно опасный эффект в HCAI. Он создаёт ложную агентность, при которой пользователь делегирует критическое мышление машине, веря, что она «знает лучше». Это может быть уместно в системах рекомендаций, но катастрофично — в медицине, юриспруденции, образовании.

Сценарии нежелательного поведенческого влияния

Примеры ситуаций, где ИИ оказывает неблагоприятное поведенческое влияние:

1. ИИ-система диагностики предлагает агрессивное лечение → пациент не задаёт вопросы, полагая, что «ИИ знает».

2. Автоматизированный модератор блокирует комментарий → пользователь не понимает причину и уходит из сервиса.

3. Рекомендательный алгоритм формирует узкий новостной пузырь → пользователь не осознаёт ограниченность информации.

Общий паттерн: снижение критического мышления, привычная делегация, исчезновение ощущаемого выбора.

Системное и критическое мышление в UX

Проектирование пользовательского взаимодействия с интеллектуальными системами требует не только эмпатии и понимания потребностей пользователя, но и способности мыслить более масштабно и структурно. Системное и критическое мышление становятся необходимыми когнитивными инструментами, позволяющими специалисту по HCAI видеть технологию в контексте, выявлять слабые звенья, прогнозировать побочные эффекты и проектировать интерфейсы, учитывающие поведенческие, социальные и когнитивные последствия.

Системное мышление предполагает способность воспринимать продукт не как изолированный интерфейс, а как элемент сложной взаимосвязанной системы. Это мышление об интерфейсе в контексте платформы, бизнеса, пользователя, алгоритма и общества. Любое изменение — будь то алгоритм рекомендаций, механизм автоматизации или оформление кнопки выбора — может вызывать каскад последствий: от изменения поведения пользователя до формирования новых привычек, искажения выбора и даже изменения отношения к себе. В рамках HCAI системное мышление позволяет специалисту заранее оценивать такие связи, понимать, где и как конкретный дизайн влияет на восприятие, интерпретацию и решения пользователя.

Применение системного подхода особенно актуально в тех случаях, когда ИИ не только реагирует на действия пользователя, но и проактивно формирует поведение. Например, рекомендательная система, предлагающая контент без объяснения принципов работы, может влиять на мотивацию пользователя, искажать восприятие мира, создавать информационные пузыри. Системное мышление позволяет видеть эти риски заранее: оно требует учитывать не только пользовательские цели, но и динамику поведения во времени, связь между алгоритмическими решениями и когнитивными эффектами.

Критическое мышление, в свою очередь, фокусируется на способности анализировать, интерпретировать и переосмысливать решения, предлагаемые как людьми, так и системами. В контексте HCAI это означает постоянный вопрос: что стоит за этим алгоритмом? какие данные легли в основу модели? какие альтернативы были исключены? критически мыслящий специалист не принимает технологию как нейтральную — он осознаёт, что любая система содержит идеологию, приоритеты и потенциальные ограничения. Это мышление направлено на выявление искажений, непреднамеренных манипуляций, ограничений выбора.

В пользовательском опыте критическое мышление также проявляется в проектировании механизмов, позволяющих самому пользователю осознавать, что делает система. Простой пример — возможность отключить автоматические рекомендации, получить объяснение решения или выбрать альтернативу. В ситуации, когда ИИ предлагает «наилучший выбор», критически мыслящий дизайнер задаёт вопрос: почему этот выбор считается наилучшим? как это воспринимается пользователем? какие возможны последствия? Вместо того чтобы усиливать доверие без проверки, такой специалист строит архитектуру, в которой доверие возникает через прозрачность, объяснение и возможность вмешательства.

Сочетание системного и критического мышления формирует новое понимание роли UX-дизайнера в HCAI. Это уже не просто проектировщик визуальных паттернов и экранов, а архитектор поведения, посредник между пользователем и алгоритмом. Такой специалист работает на уровне модели восприятия, прогнозирует поведение, закладывает механизмы обратной связи и устойчивости. Его задача — не только создавать удобство, но и обеспечивать осмысленное, безопасное и когнитивно устойчивое взаимодействие между человеком и ИИ.

Таким образом, системное и критическое мышление в контексте HCAI становятся не факультативной компетенцией, а основой проектной деятельности. Они позволяют переходить от реактивного дизайна, исправляющего ошибки после внедрения, к упреждающему — который предотвращает проблемы ещё на стадии идеи. Только с таким подходом возможно создание действительно человеко-ориентированных интеллектуальных систем.

ключевые термины главы 2

Когнитивная нагрузка (Cognitive Load) — Объём умственной активности, требуемой пользователю для понимания интерфейса, принятия решений или выполнения задач.

Внимание — Ограниченный когнитивный ресурс, распределяемый между объектами, задачами и сигналами; основа эффективного восприятия интерфейса.

Восприятие — Психологический процесс преобразования сенсорной информации в осмысленные образы и структуры.

Кратковременная память — Механизм хранения ограниченного объёма информации в течение короткого времени, участвующий в выполнении текущих действий.

Долговременная память — Устойчивое хранение информации, формируемое на основе повторений, смысловых связей и эмоциональной значимости.

Гештальт-принципы — Когнитивные правила, по которым человек группирует и интерпретирует визуальные объекты (близость, сходство, завершённость).

Рациональное поведение — Поведение, соответствующее модели оптимизации: выбор, основанный на полной информации и логике.

Ограниченная рациональность — Модель, признающая когнитивные и информационные ограничения человека при принятии решений.

Эвристика — Ментальное правило или паттерн, упрощающий принятие решений в условиях неопределённости или перегрузки.

Когнитивное искажение (bias) — Систематическое отклонение в суждениях, приводящее к ошибочным решениям или восприятию.

Система 1 / Система 2 — Теория мышления (Канеман): автоматическое (интуитивное) и контролируемое (аналитическое) мышление.

Автоматизация — Делегирование задачи ИИ или цифровой системе, снижающее участие пользователя в процессе выполнения.

Automation bias — Склонность человека переоценивать корректность автоматизированных решений и недооценивать ошибки.

Overtrust / Undertrust — Избыточное или недостаточное доверие к системе, влияющее на поведение и принятие решений.

Переоценка ИИ (Anthropomorphism) — Приписывание ИИ человеческих качеств — эмоций, намерений, сознания.

Агентность (Agency) — Способность пользователя осознанно влиять на поведение системы и принимать автономные решения.

Системное мышление — Навык видеть продукт как часть взаимосвязанной системы, с учётом всех уровней и последствий изменений.

Критическое мышление — Способность анализировать и интерпретировать информацию, оценивать обоснованность выводов и принимать решения с учётом контекста.

UX-профилактика — Подход к проектированию взаимодействия, при котором ошибки и негативные сценарии предотвращаются ещё на этапе концепции.

Архитектура поведения — Проектирование пользовательского опыта как структуры когнитивных, эмоциональных и поведенческих паттернов, управляемых системой.

Глава 3. UX-исследования и аналитика

Планирование UX/AI-исследований: цели, гипотезы, методы

Исследование в UX и HCAI — это не разовая процедура, направленная на сбор обратной связи, а фундаментальный этап проектирования, без которого невозможно принять обоснованные решения о структуре, поведении и логике интерфейса. Особенно в контексте ИИ-систем, чьё поведение адаптивно, вероятностно и не всегда интерпретируемо, качественно спланированное исследование позволяет выявить неочевидные барьеры, скрытые искажения, поведенческие риски и когнитивные нагрузки, которые не могут быть предсказаны методом экспертной оценки.

В отличие от классического UX, в исследованиях HCAI фокус смещается с оценки визуальных паттернов и удобства навигации на изучение взаимодействия пользователя с интеллектуальной логикой системы, включая восприятие объяснимости, уровень доверия, ощущение агентности и способность к интерпретации предложений или решений. Это требует не просто применения существующих методик, но и их адаптации к новым условиям — когда система не статична, а активно влияет на поведение и интерпретацию.

Процесс исследования начинается с постановки целей. В UX и HCAI цели не сводятся к «понравилось/не понравилось» или «понял/не понял». Они связаны с изучением когнитивного и поведенческого контекста: как пользователь интерпретирует поведение системы, где возникают когнитивные конфликты, как пользователь реагирует на автономные решения, в каком месте снижается уверенность или теряется контроль.

Цель исследования может быть направлена на:

— выявление критических точек в пользовательском сценарии;

— понимание, как пользователь объясняет поведение ИИ;

— проверку, насколько рекомендации воспринимаются как адекватные;

— оценку устойчивости доверия после ошибок системы;

— сбор данных о различиях в восприятии у разных сегментов пользователей (например, новички против опытных; молодые против пожилых).

После постановки целей формируется гипотеза — предположительное утверждение, которое можно подтвердить или опровергнуть эмпирически. Гипотеза в UX/AI-исследовании должна быть операционализирована: то есть иметь понятное поведенческое выражение, по которому можно судить о её справедливости. Например, гипотеза может звучать как: «Пользователи будут склонны принимать рекомендации ИИ, если система визуально показывает уровень своей уверенности». Или: «Добавление краткого объяснения решения ИИ повысит уровень субъективного доверия и снизит количество отказов от действия».

Методы исследования подбираются в зависимости от цели и гипотезы. В UX/HCAI они делятся на качественные, количественные и смешанные. Качественные методы позволяют понять внутреннюю логику пользователя, его интерпретации, эмоции и восприятие. Количественные — дают статистические показатели: доли успешных задач, уровень вовлечённости, продолжительность взаимодействия, ошибки, отклонения от ожидаемого поведения. Смешанные методы позволяют комбинировать глубину качественного подхода с репрезентативностью количественного.

При выборе метода необходимо учитывать:

— тип интерфейса (визуальный, голосовой, рекомендательный);

— степень адаптивности ИИ (насколько его поведение зависит от пользователя);

— ожидаемую когнитивную нагрузку;

— уровень зрелости продукта (прототип или действующая система);

— контекст исследования (лабораторное или полевое, дистанционное или вживую).

Исследования могут быть формативными — направленными на понимание текущего состояния и выявление проблем, или суммативными — проверяющими эффект изменений после итерации. В HCAI оба подхода применяются одновременно, потому что ИИ-система может менять поведение во времени, а значит, формативный анализ должен проводиться регулярно даже в работающем продукте.

Важно также учитывать роль наблюдателя. В UX-исследованиях наблюдение может повлиять на поведение пользователя — особенно при изучении взаимодействия с интеллектуальной системой, где пользователь может неосознанно подстраиваться под предполагаемое поведение «умного» интерфейса. Это требует строгого соблюдения нейтральности, чёткого сценария интервью и контроля за вмешательством в ход эксперимента.

Планирование UX/AI-исследования включает:

1. постановку исследовательских вопросов и целей;

2. формулирование проверяемых гипотез;

3. выбор методов: интервью, тестирование, лог-анализ, анкетирование;

4. определение метрик:

— подбор респондентов (репрезентативных по отношению к целевой аудитории);

— разработку сценариев задач и вопросов;

— соблюдение этических процедур (информированное согласие, анонимизация и др.).

Процесс планирования не является линейным. Цель, гипотеза и метод взаимно влияют друг на друга. Иногда гипотеза формируется после первичных наблюдений. Иногда метод диктуется контекстом (например, невозможностью провести очное наблюдение). Ключевой навык исследователя HCAI — гибко управлять этой структурой, не теряя научной строгости.

План — это не просто список шагов. Это инструмент, обеспечивающий валидность, воспроизводимость и интерпретируемость данных. Особенно в работе с ИИ, где поведение модели может меняться, а пользователь — не всегда осознаёт границы своего взаимодействия, качественное планирование превращается в акт архитектуры: заранее задавая рамки интерпретации, мы управляем тем, какой опыт становится видимым, а какой — ускользает.

Качественные методы: интервью, наблюдения, CJM, карты эмпатии

Качественные методы в UX-исследованиях позволяют выйти за рамки статистических показателей и изучить внутренние когнитивные, эмоциональные и поведенческие механизмы взаимодействия человека с системой. В контексте HCAI это особенно важно, так как взаимодействие с ИИ включает в себя интерпретацию решений модели, доверие, ощущение контроля и субъективное понимание агентности. Качественные исследования дают возможность увидеть не только, что пользователь делает, но и как он это объясняет, какие смыслы приписывает системе и что остаётся за пределами измеряемых метрик.

В отличие от количественных исследований, ориентированных на числовые показатели, качественные методы направлены на глубинное понимание индивидуального опыта. Они позволяют фиксировать противоречия, когнитивные пробелы, эмоциональные реакции и сформировать основание для генерации гипотез, которые в дальнейшем могут быть проверены количественно. Их особенность — в открытости, гибкости и ориентации на контекст, а не на стандартизированную процедуру.

Один из базовых методов — глубинное интервью. Оно позволяет исследователю понять, как пользователь воспринимает систему, как интерпретирует её поведение, что считает логичным, а что — непредсказуемым или тревожным. В случае ИИ-интерфейсов это может быть, например, вопрос о том, почему пользователь решил отказаться от рекомендованного действия, что он подумал, увидев определённый вывод модели, или как он определяет, что системе можно доверять. Интервью проводится по полуструктурированному сценарию, где задана логика тем, но вопросы формулируются гибко, позволяя уточнять, углубляться и реагировать на неожиданные направления. Анализ интервью включает этап кодирования — выделения тем, паттернов, повторяющихся смыслов — и может проводиться вручную или с помощью программного обеспечения (например, NVivo, Atlas. ti).

Другой метод — наблюдение. В HCI оно применяется как в лабораторных, так и в полевых условиях. В контексте HCAI наблюдение особенно ценно, так как поведение пользователя по отношению к ИИ может не совпадать с тем, как он это описывает. Например, пользователь может утверждать, что принимает решения сам, но наблюдение покажет, что он механически следует предложению системы, не анализируя альтернативы. Наблюдение может быть пассивным (без вмешательства) и активным (с уточняющими вопросами по ходу). Также важно учитывать возможность эффектов наблюдателя — изменение поведения из-за осознания, что за пользователем следят.

Customer Journey Mapping (CJM) — инструмент, позволяющий визуализировать путь пользователя при выполнении задачи или взаимодействии с системой. Он включает стадии, цели, точки контакта, эмоции и возможные барьеры. В случае HCAI особенно важно фиксировать:

— моменты, где вмешивается ИИ;

— изменения в ощущении контроля;

— эмоциональные пики — например, тревожность, растерянность, облегчение;

— недостающие элементы — где пользователь не получил обратной связи или объяснения.

CJM создаётся по данным интервью, наблюдений и тестов. Он помогает команде увидеть не интерфейс, а переживание, включая когнитивную и эмоциональную составляющие. Это делает его важным инструментом этически осознанного дизайна.

Карты эмпатии (empathy maps) — метод визуального представления того, что пользователь чувствует, думает, говорит и делает. В рамках HCAI они применяются для выявления когнитивных и аффективных реакций на поведение ИИ. Например, пользователь может внешне одобрять предложение системы, но при этом внутренне сомневаться. Карта эмпатии позволяет визуально выделить такие расхождения. Это ценный инструмент для выявления скрытых проблем в доверии, восприятии прозрачности, эмоционального напряжения. Карты строятся на основе цитат, наблюдений, анализа невербальных реакций, а также мета-анализа поведенческих данных (например, задержки перед нажатием кнопки, возвращение к предыдущему шагу).

Все эти методы применимы как по отдельности, так и в комплексе. В качественном UX/AI-исследовании они часто комбинируются: наблюдение фиксирует поведение, интервью — смыслы, карта эмпатии — переживания, CJM — структуру опыта. Это позволяет выстроить многослойную модель взаимодействия, в которой каждый уровень дополняет другой. Для ИИ это особенно важно, поскольку поверхностное понимание поведения без осмысления когнитивных и эмоциональных механизмов приводит к искажённому UX и ошибкам проектирования.

Сильная сторона качественных методов — чувствительность к нюансам. Они улавливают слабые сигналы: недоумение, неуверенность, внутренние конфликты, которые не видны в логах. Слабая сторона — меньшая масштабируемость и высокая зависимость от исследователя. Поэтому к ним предъявляются строгие требования по подготовке, этике, интерпретации и обоснованию выводов. В контексте HCAI они становятся обязательной частью исследовательского цикла: только благодаря качественным методам можно получить доступ к глубинным основаниям поведения, на которые интеллектуальные системы влияют наиболее незаметно.

Количественные методы: A/B-тесты, лог-анализ, task success, error rate

Количественные методы в UX- и HCAI-исследованиях предназначены для получения измеримых, воспроизводимых и статистически интерпретируемых данных о взаимодействии пользователя с системой. В отличие от качественных подходов, фокус которых направлен на интерпретацию и контекст, количественные методы позволяют судить о масштабах, распределениях, значимости различий и степени выраженности тех или иных эффектов. В условиях работы с ИИ-интерфейсами эти методы становятся особенно ценными, так как позволяют фиксировать объективные изменения в поведении пользователя, вызванные алгоритмическими вмешательствами, перестройкой интерфейса или модификацией логики взаимодействия.

Бесплатный фрагмент закончился.

Купите книгу, чтобы продолжить чтение.